|

|

MADRID, 27 (Portaltic/EP)

Google ha anunciado que está tomando "medidas rápidas" para eliminar resultados inexactos proporcionados por su función de Inteligencia Artificial (IA) AI Overview, impulsada por Gemini, que recientemente ha recomendado a los usuarios comer piedras como parte de una dieta o echarle pegamento a la pizza.

La firma presentó a Gemini a finales del año pasado como una IA flexible que se puede ejecutar tanto en centros de datos como en dispositivos móviles, motivo por el que se ofrece en tres tamaños diferentes (Ultra, Pro y Nano).

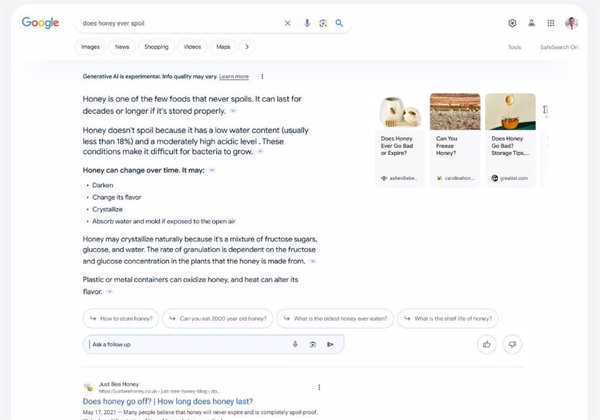

Hace unas semanas, Google presentó novedades para esta herramienta, entre las que se encuentra AI Overview, que ofrece respuestas rápidas con resúmenes creados por IA y que desde entonces está disponible en Estados Unidos.

Esta funcionalidad, que es un experimento de Search Labs, ha reemplazado a la Experiencia generativa de búsqueda (SGE, por sus siglas en inglés), una solución experimental que permitía llevar la IA generativa a la búsqueda de los usuarios para ofrecerles descripciones generales y más enlaces con el objetivo de ofrecer múltiples perspectivas.

Desde su implementación, AI Overview ha generado una serie de respuestas incorrectas que los usuarios que la han probado han compartido en sus redes sociales. Entre ellas, la recomendación de "comer al menos una piedra pequeña al día, según geólogos de la Universidad de Berkeley", según ha compartido la usuaria Kris Kashtanova en su perfil de X.

Otro usuario identificado en esta red social como @heavenred ha señalado que AI Overview le recomendó utilizar pegamento "no tóxico" en una pizza para que el queso se fundiera con la masa.

La compañía ha asegurado que su herramienta genera en gran medida "información de alta calidad" y ha justificado que estas respuestas se deben a "consultas poco comunes", además de que se podrían haber manipulado, en palabras de su portavoz, Meghann Garnsworth, recogidas por The Verge.

Para acabar con las también conocidas como alucinaciones -respuestas que a pesar de parecer coherentes incluyen información sesgada o errónea que no está respaldada por los datos con los que se ha entrenado-, Google está tomando "medidas rápidas" para acabar con estas respuestas.

Asimismo, ha matizado que busca eliminar las descripciones generales de IA en determinadas consultas "cuando corresponda", de acuerdo a sus políticas de contenido. Para ello, utilizará estos ejemplos de respuestas inexactas, con las quetrabajará para desarrollar mejoras "más amplias" en sus sistemas.

|